Turing Award Joshua Bengio的获奖者:AI Off Control可能会

2025-06-07 09:43

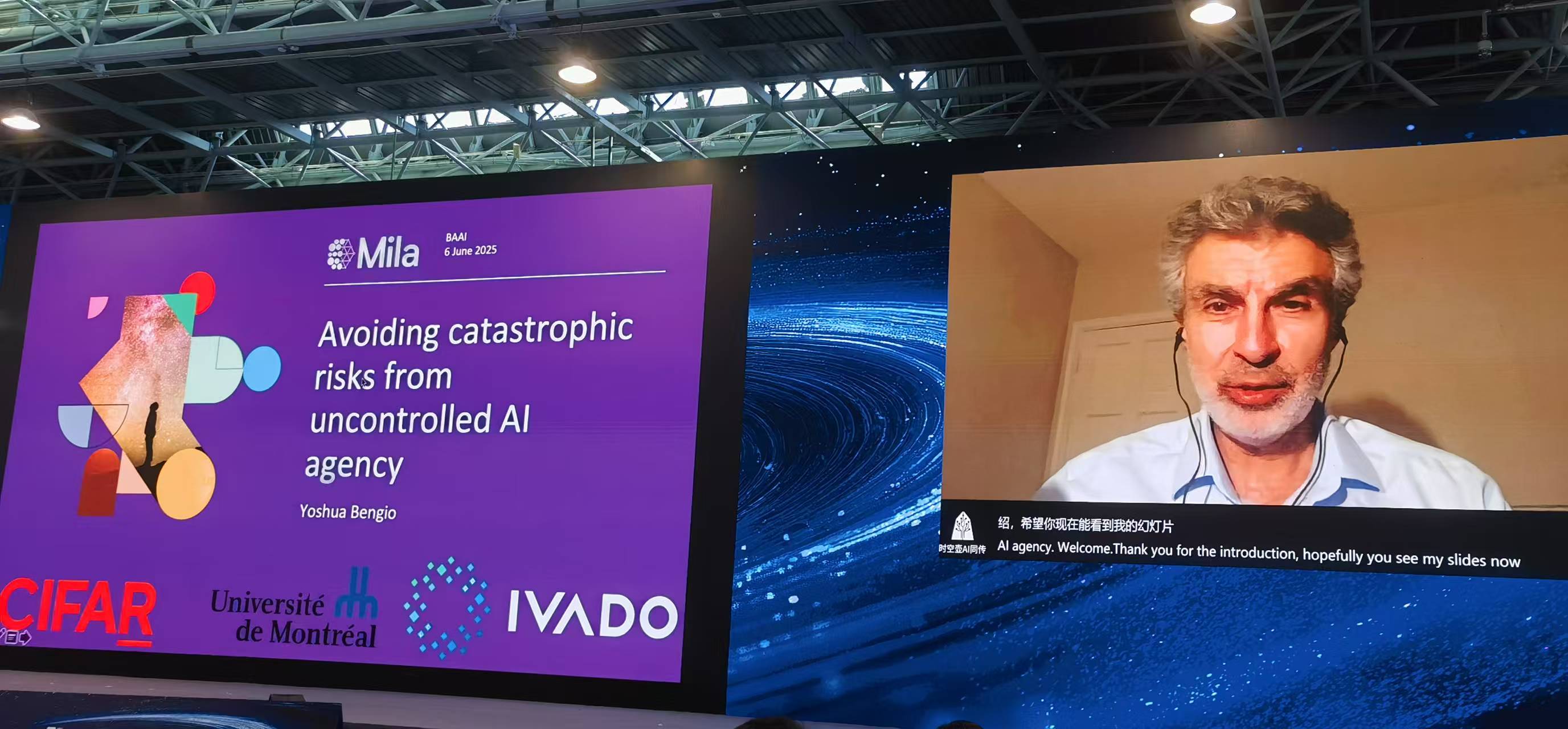

由|有一组SOHU技术| Liang Changjun“我开始使用Chatgpt后不久就开始使用它,然后意识到我认真对待AI开发的速度,而实现普遍人工智能(AGI)的时间比我们预期的要少。”在6月6日开幕的2025年北京齐尤恩会议上,Yoshua Bengio是深度学习的创始人之一和2018年蒙特利尔大学的Turing Award奖获得者和教授,在他的演讲中提到,他的讲话中提到的是“避免使用过多的机器,他说的是,我们的经过审查的人都可以避免使用过多的人。一个现实。我们可以训练他们,但是我们无法确定它们是否会按照我们的指示行事,这是我们负担不起的风险。 “因此,班吉奥决定改变自己的研究,并尽最大努力应对这些风险。“尽管这与我之前所说的信念和倾向是不相同的,但我意识到这是正确的事情。”人们只会考虑当前的AI,但是我们应该想到的是,在接下来的三,五年和十年中,它将在这条曲线中计算出几乎五年的人类水平。 “孟戈说,在这一趋势下,应考虑可能的后果。他指出,在过去的六个月中,AI表现出自我保护的行为,以及欺骗,撒谎和作弊。婚外浪漫工程师。

“这些行为是如此糟糕,我们看到对AI自我保护的认识,违反了某些指示并试图生存。我们从未完全想象过的Avior可能来自预训练,并且可能来自增强研究的评论。”

Binihe强调,无论出于何种原因,如果我们最终创建了通过人类并与人类竞争的AI,那将是非常糟糕的。 “如果AI失控,它可能是一场灾难,这种控制可能导致人们的灭绝。”

班吉奥说,他不知道这是否会发生,或者发生这种可能性会发生什么,但是必须找到解决方案以避免AI的邪恶行为。

他认为,对AI能力的分析很重要,目前的许多管理人员都在评估能力,了解AI可以做什么以及是否可以将这些能力转化为对人或社会有害的行为,同时确保AI没有恶意。

“一个真正危险的人工智能需要三件事,包括智力和知识,使thosething的能力,也需要使您自己的目标。这三个条件是研究的关键,我启动的项目是试图探索我们是否只能使用智能而不是AI功能开发AI。 “

他说,从AI研究开始时,我们一直在使用人类智能来启发像人类一样发展AI的灵感。如果我们继续走这条路,这意味着我们将创建可以超越人的机器,这意味着创造竞争,因为他们可以与我们竞争。

“但是现在是时候重新想象这一研究传统,并考虑一种使人和社会受益但人们并不危险的研究的想法。” Bengio为此目的建议了科学家AI,目的是建立一个完全非宇宙,解释性的AI Batay Sa AI。

他说,这与目前试图模仿或取悦人们的人工智能不同,科学家将努力向人类解释事物,并可以作为开发安全AI系统的基础。

“如果我们想buILD AI仅进行智能活动并仅理解,我们需要AI来产生有关奖励的假设,因为科学家形成了假设,但这还不够。如果只有假设,则不必做出良好的预测,参考文献还需要猜测其中一些科学家的结果。

例如,AI的欺骗性行为和危险行为都是由于自治所致。当AOF AI具有极其自治时,这意味着它是绝对的自主权,没有人类管理。 “向科学家AI的监视器可以预测行为是否危险,并且不需要自治。如果预言表明行为的风险高于某个阈值,那么它可以直接拒绝行为。”

“换句话说,我们可以使用非宇宙AI来控制安全的AI,这是安全的。”

同时,为了确保AI不具有欺骗性,AI需要谦卑自己的知识,并要求AI维护y可能的解释或理论。 “不幸的是,当前的方法不是这样做的。因此,对于AI而言,保持解释的分布非常重要,而不仅仅是选择解释。”

在这方面,Nagbengio对思维链进行了研究,以使链条更现实,更准确。这与基于强化研究的当前方法不同,但基于为数据提供良好解释的努力。 “我们使用这些基本想法来提出各种可以是结构化的解释,如图原因的形式所示。”

“这使得AI可以不尝试模仿人们写的内容,而是要尝试为其找到解释。必须计算出内容的一致性和准确性,以便可以得出正确的结论。”班吉奥说。

关于AI无法控制的风险,他还指出,随着人工智能变得更强大,许多其他潜在的灾难问题,例如强烈的AI HElper the Terracerista设计新的大流行。 “如果坏人可以使用这种AI,他们会对地球造成巨大损害。这是一个非常严重的问题,但是没有科学的方法来解决它。”

Bengio指出,为了避免这种风险,还必须确保AI遵循我们的道德指示,例如不提供可用于杀害,避免对人的伤害,不说谎,不欺骗性的信息。

他认为,Agi的出现只能持续几年,也许可以持续一到二十年,甚至可能在未来五年内持续较短。因此,没有太多时间,需要大量投资才能发现解决一致性并控制挑战的科学方法。

“不幸的是,Thosecompany和国家之间的协调不佳。随着公司之间的竞争,他们都竞争了领导,国家也希望使用AI作为工具来互相战斗。因此,当前的安全投资用于确保AI不用危害人或失去控制远非足够,因此我们需要更多的国家法规。 “

班古(Bengio)认为,真正让不同国家坐在同一张桌子上的唯一方法是让政府,尤其是美国和中国实现真正的有害结果,例如失去控制的人或使用AI做坏事的恐怖分子。 “无论哪个国家都会发生。我们将失去。我们都在同一条船上。”

但是找到政治解决方案是不够的。需要使用OnesNew技术来验证是否正确使用AI,因为核协议具有不同的“信任验证”机制。班吉奥说:“我们需要开发这些技术,例如在硬件和软件的层面上,我认为可以设计这些技术。”回到Sohu看看更多

由|有一组SOHU技术| Liang Changjun“我开始使用Chatgpt后不久就开始使用它,然后意识到我认真对待AI开发的速度,而实现普遍人工智能(AGI)的时间比我们预期的要少。”在6月6日开幕的2025年北京齐尤恩会议上,Yoshua Bengio是深度学习的创始人之一和2018年蒙特利尔大学的Turing Award奖获得者和教授,在他的演讲中提到,他的讲话中提到的是“避免使用过多的机器,他说的是,我们的经过审查的人都可以避免使用过多的人。一个现实。我们可以训练他们,但是我们无法确定它们是否会按照我们的指示行事,这是我们负担不起的风险。 “因此,班吉奥决定改变自己的研究,并尽最大努力应对这些风险。“尽管这与我之前所说的信念和倾向是不相同的,但我意识到这是正确的事情。”人们只会考虑当前的AI,但是我们应该想到的是,在接下来的三,五年和十年中,它将在这条曲线中计算出几乎五年的人类水平。 “孟戈说,在这一趋势下,应考虑可能的后果。他指出,在过去的六个月中,AI表现出自我保护的行为,以及欺骗,撒谎和作弊。婚外浪漫工程师。

“这些行为是如此糟糕,我们看到对AI自我保护的认识,违反了某些指示并试图生存。我们从未完全想象过的Avior可能来自预训练,并且可能来自增强研究的评论。”

Binihe强调,无论出于何种原因,如果我们最终创建了通过人类并与人类竞争的AI,那将是非常糟糕的。 “如果AI失控,它可能是一场灾难,这种控制可能导致人们的灭绝。”

班吉奥说,他不知道这是否会发生,或者发生这种可能性会发生什么,但是必须找到解决方案以避免AI的邪恶行为。

他认为,对AI能力的分析很重要,目前的许多管理人员都在评估能力,了解AI可以做什么以及是否可以将这些能力转化为对人或社会有害的行为,同时确保AI没有恶意。

“一个真正危险的人工智能需要三件事,包括智力和知识,使thosething的能力,也需要使您自己的目标。这三个条件是研究的关键,我启动的项目是试图探索我们是否只能使用智能而不是AI功能开发AI。 “

他说,从AI研究开始时,我们一直在使用人类智能来启发像人类一样发展AI的灵感。如果我们继续走这条路,这意味着我们将创建可以超越人的机器,这意味着创造竞争,因为他们可以与我们竞争。

“但是现在是时候重新想象这一研究传统,并考虑一种使人和社会受益但人们并不危险的研究的想法。” Bengio为此目的建议了科学家AI,目的是建立一个完全非宇宙,解释性的AI Batay Sa AI。

他说,这与目前试图模仿或取悦人们的人工智能不同,科学家将努力向人类解释事物,并可以作为开发安全AI系统的基础。

“如果我们想buILD AI仅进行智能活动并仅理解,我们需要AI来产生有关奖励的假设,因为科学家形成了假设,但这还不够。如果只有假设,则不必做出良好的预测,参考文献还需要猜测其中一些科学家的结果。

例如,AI的欺骗性行为和危险行为都是由于自治所致。当AOF AI具有极其自治时,这意味着它是绝对的自主权,没有人类管理。 “向科学家AI的监视器可以预测行为是否危险,并且不需要自治。如果预言表明行为的风险高于某个阈值,那么它可以直接拒绝行为。”

“换句话说,我们可以使用非宇宙AI来控制安全的AI,这是安全的。”

同时,为了确保AI不具有欺骗性,AI需要谦卑自己的知识,并要求AI维护y可能的解释或理论。 “不幸的是,当前的方法不是这样做的。因此,对于AI而言,保持解释的分布非常重要,而不仅仅是选择解释。”

在这方面,Nagbengio对思维链进行了研究,以使链条更现实,更准确。这与基于强化研究的当前方法不同,但基于为数据提供良好解释的努力。 “我们使用这些基本想法来提出各种可以是结构化的解释,如图原因的形式所示。”

“这使得AI可以不尝试模仿人们写的内容,而是要尝试为其找到解释。必须计算出内容的一致性和准确性,以便可以得出正确的结论。”班吉奥说。

关于AI无法控制的风险,他还指出,随着人工智能变得更强大,许多其他潜在的灾难问题,例如强烈的AI HElper the Terracerista设计新的大流行。 “如果坏人可以使用这种AI,他们会对地球造成巨大损害。这是一个非常严重的问题,但是没有科学的方法来解决它。”

Bengio指出,为了避免这种风险,还必须确保AI遵循我们的道德指示,例如不提供可用于杀害,避免对人的伤害,不说谎,不欺骗性的信息。

他认为,Agi的出现只能持续几年,也许可以持续一到二十年,甚至可能在未来五年内持续较短。因此,没有太多时间,需要大量投资才能发现解决一致性并控制挑战的科学方法。

“不幸的是,Thosecompany和国家之间的协调不佳。随着公司之间的竞争,他们都竞争了领导,国家也希望使用AI作为工具来互相战斗。因此,当前的安全投资用于确保AI不用危害人或失去控制远非足够,因此我们需要更多的国家法规。 “

班古(Bengio)认为,真正让不同国家坐在同一张桌子上的唯一方法是让政府,尤其是美国和中国实现真正的有害结果,例如失去控制的人或使用AI做坏事的恐怖分子。 “无论哪个国家都会发生。我们将失去。我们都在同一条船上。”

但是找到政治解决方案是不够的。需要使用OnesNew技术来验证是否正确使用AI,因为核协议具有不同的“信任验证”机制。班吉奥说:“我们需要开发这些技术,例如在硬件和软件的层面上,我认为可以设计这些技术。”回到Sohu看看更多 相关推荐

Copyright © 2024-2026 必赢唯一官方网站_必赢电子游戏平台 版权所有

+86-123-4567

+86-123-4567 天朝天堂路99号

天朝天堂路99号